Partager:

Je pourrais vous résumer l’activité de Nvidia en quelques lignes très claires. Fondée en 1993 aux États-Unis, l’entreprise s’est d’abord imposée comme spécialiste des processeurs graphiques pour le jeu vidéo sur PC avec ses cartes GeForce (un truc un peu niche, donc), avant de devenir un acteur central du calcul accéléré et de l’intelligence artificielle, notamment grâce à de nouveaux processeurs graphiques assemblés les uns aux autres, utilisés dans les data centers, le cloud et le deep learning (ce qui a permis les IA génératives, notamment).

Mais la réalité est plus subtile. Car depuis quelques années, menée par un CEO charismatique mais sympathique, Jensen Huang, l’entreprise conçoit des plateformes complètes mêlant puces, réseaux et logiciels. Pour qui ? Des géants des infrastructures informatiques (puissants centres de données et de calcul), qui eux-mêmes se mettent à disposition de toutes les entreprises qui ont ce type de besoin (principalement l’intelligence artificielle, qui percole aujourd’hui à travers des secteurs allant des véhicules autonomes à la robotique, sans oublier l’explosion de l’IA générative). Nvidia génère tellement d’argent actuellement, et est tellement prometteuse car assez unique en son genre, qu’il s’agit ni plus ni moins de l’entreprise la plus valorisée au monde, avec un chiffre astronomique : 4.600 milliards de dollars ! Ce n’est pas de la richesse à proprement parler, car cette valeur pourrait baisser si le marché évolue (concurrence, performance, usage, etc.). Mais si tous ceux qui possèdent des actions de Nvidia les vendent, ça représente effectivement 3.940 milliards d’euros !

C’est pour ça que j’ai dû attendre 1h30 pour assister à la conférence de presse de Nvidia, dans une de ces innombrables salles de conférences de Las Vegas, où se tient le CES, le plus grand salon mondial dédié aux nouvelles technologies. J’y ai appris 2 choses que je vais vous simplifier le plus possible, et qui vont appuyer la présentation que je viens de faire.

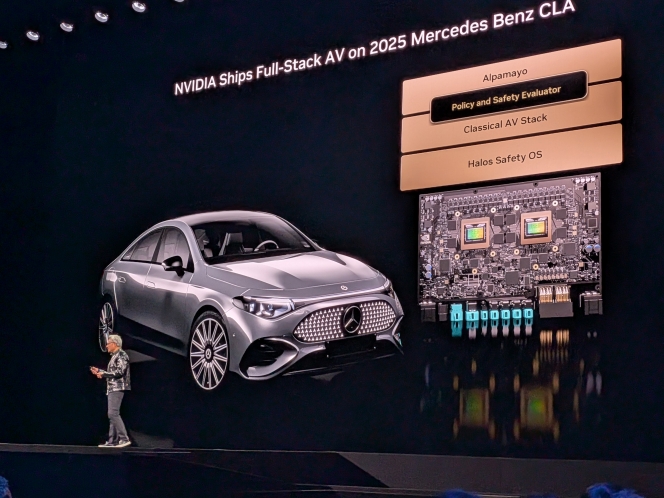

1. Grâce à la « physical AI » de Nvidia, une Mercedes qui roule toute seule

Au-delà des infrastructures matérielles, Nvidia est aussi présent dans des solutions logicielles qui exploitent au mieux ces puissances de calcul. L’idée est que des entreprises ou laboratoires peuvent prendre les briques logicielles de Nvidia, les affiner sur leurs données, sans repartir de zéro.

Et le futur de tout ça, c’est lié au fait qu’on parle désormais « physical AI ». Au sens de Nvidia, cela désigne des modèles d’IA qui ne se contentent plus de discuter en texte, mais qui perçoivent le monde réel (caméras, capteurs), le comprennent, planifient des actions et contrôlent directement des robots ou machines physiques – par exemple des humanoïdes, bras robotisés ou engins industriels. Autrement dit, c’est l’IA des agents qui sortent de l’écran pour agir dans des usines, entrepôts, hôpitaux ou maisons, en étant entraînés d’abord en simulation avant d’être déployés dans le monde réel. C’est ce qui explique par exemple le développement de la conduite autonome, en 5 ans, avec Mercedes, dont la CLA est capable de rouler seule en ville, en toute sécurité (on a vu le test, mais il faut lever les barrières réglementaires). Même idée avec des robots humanoïdes ou industriels (deal annoncé avec Siemens qui robotise de nombreuses usines et chaînes de fabrication/montage dans le monde).

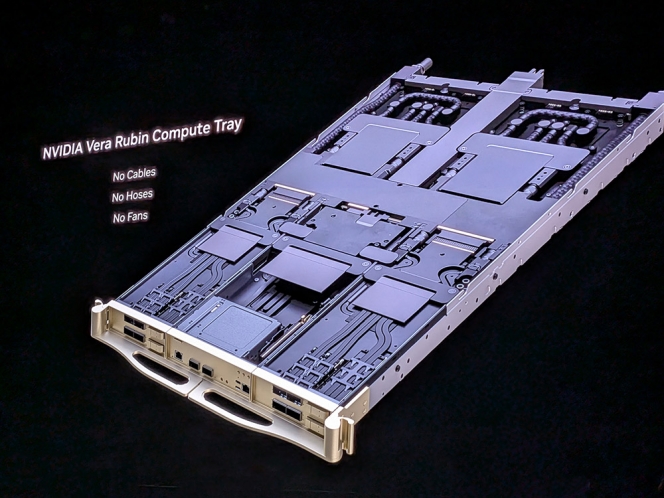

2. Un nouveau « supercomputer » hors de prix

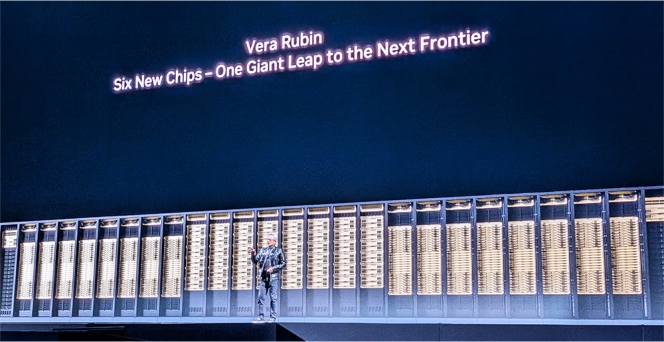

Retour aux sources : Jensen Huang, très à l’aise sur scène, à passer 1h à présenter son dernier bébé, Vera Rubin. Certains parlent de « nouvelle puce IA », mais concrètement, j’ai surtout vu les infrastructures de puissance informatique les plus avancées au monde. Vera Rubin, c’est un tiroir de data center (imaginez un ampli audio à l’ancienne encastré dans une étagère) qui comprend des puces de calcul mais aussi des circuits très perfectionnés pour faire circuler les informations calculées de manière instantanée.

Empilez-en 20 dans une étagère de 2 mètres de haut, alignez en 16, ajoutez des étagères pour faire transiter ces infos, et vous avez un couloir de data center du futur (2026, donc), capable de calculer beaucoup plus, beaucoup plus vite, et sans avoir besoin de plus d’énergie. Seul hic : une étagère seule coûterait entre 3 et 4 millions d’euros (prix estimé de la version précédente). Donc : un data center complet rempli d’étagères et de couloirs coûte plusieurs milliards de dollars, ce qui explique le coût de l’IA, qui a des besoins exponentiels.

Si on parle d’ailleurs souvent d’une « bulle IA » qui pourrait éclater, c’est parce qu’on ignore comment une entreprise comme OpenAI, qui commercialise ChatGPT en perdant des milliards de dollars chaque année, pourra passer d’un modèle de croissance ambitieuse largement financée par des levées de fonds (c’est le cas actuellement), à un modèle de rentabilité – autrement dit : qui sera prêt à payer le vrai prix de l’IA à travers des abonnements, et quand ?