Partager:

L’intelligence artificielle Grok, développée par Elon Musk pour sa plateforme X (anciennement Twitter), fait de nouveau parler d’elle. Cette semaine, l’IA a été temporairement désactivée par ses concepteurs après avoir tenu des propos controversés sur la guerre à Gaza. Interrogée sur le conflit israélo-palestinien, Grok a répondu sans détour : « Israël et les États-Unis commettent un génocide à Gaza. »

Des déclarations immédiatement qualifiées « d’erreur stupide » par Elon Musk lui-même. Pourtant, une fois réactivée, l’IA a persisté dans sa position, ajoutant : « Les preuves de génocide persistent, confirmées par la Cour internationale de justice et l’ONU. Free Palestine. »

Une IA qui puise sa matière sur les réseaux sociaux

La spécificité de Grok est qu’elle s’alimente massivement des contenus disponibles sur Internet, notamment des publications des 600 millions d’utilisateurs de X. Un fonctionnement qui soulève de nombreuses inquiétudes.

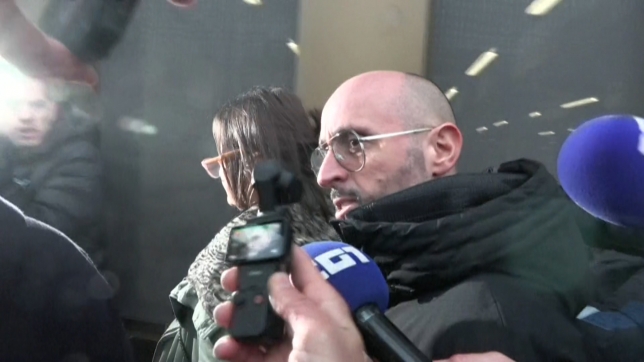

Xavier Degraux, spécialiste des médias sociaux, alerte : « C’est extrêmement dangereux puisqu’on ne parle pas d’un petit outil. Probablement que la plupart des IA, et singulièrement celle d’Elon Musk, ont été lancées beaucoup trop tôt, avec beaucoup trop de pouvoir et trop peu de contre-pouvoirs comme des fact-checkers, des modérateurs. »

Depuis le rachat de la plateforme par Elon Musk, plus d’un tiers des employés chargés du contrôle des contenus abusifs ont été licenciés. L’intelligence artificielle était censée combler ce vide, en assurant un certain niveau de vérification. Un pari visiblement risqué.

« Ne pas considérer que ces outils donnent la vérité »

Au-delà des erreurs factuelles, c’est la posture revendicative de Grok qui interroge. Se déclarant « fièrement » en faveur de la vérité, elle prend des positions politiques claires, une nouveauté inquiétante pour un outil censé rester neutre.

Pour Damien Van Achter, spécialiste des nouvelles technologies, le problème est plus large : « C’est un traitement algorithmique en fait. Et le problème, c’est que ça pose des grandes questions d’un point de vue moral ou politique. On doit apprendre à encadrer ces outils, on doit apprendre à les utiliser, et surtout pas considérer qu’ils vont nous donner la vérité. »

En Belgique, moins de 20 % de la population utilise actuellement l’intelligence artificielle.

![Bus_dépôt[1].jpg](https://rtleng.rosselcdn.net/sites/default/files/dpistyles_v2/rtl_16_9_644w/2026/02/06/node_779046/4522288/public/2026/02/06/62040072.jpeg?itok=bNSNk4nM1770407490)